EGOU-egouz官网

卷积架构已被证明在视觉任务方面非常成功。它们的硬归纳偏差使样本高效学习成为可能,但代价是可能降低性能上限。视觉变换器 (ViT) 依赖于更灵活的自注意力层,并且最近在图像分类方面的表现优于 CNN。然而,它们需要对大型外部数据集进行昂贵的预训练或从预训练的卷积网络中提取。在本文中,我们提出以下问题EGOU:是否可以结合这两种架构的优势,同时避免它们各自的局限性EGOU?为此,我们引入了门控位置自注意力(GPSA),这是一种位置自注意力的形式,可以配备“软”卷积归纳偏置。我们初始化 GPSA 层以模拟卷积层的局部性,然后通过调整调节对位置与内容信息的注意力的门控参数,让每个注意力头可以自由地逃离局部性。由此产生的类似卷积的 ViT 架构 ConViT 在 ImageNet 上优于 DeiT (Touvron et al., 2020),同时提供了大大提高的样本效率。我们通过首先量化它在vanilla self-attention 层中是如何被鼓励的,然后分析它是如何在 GPSA 层中转义的,从而进一步研究了局部性在学习中的作用。我们最后展示了各种消融,以更好地了解 ConViT 的成功。我们的代码和模型在 https://github.com/facebookresearch/convit 上公开发布。

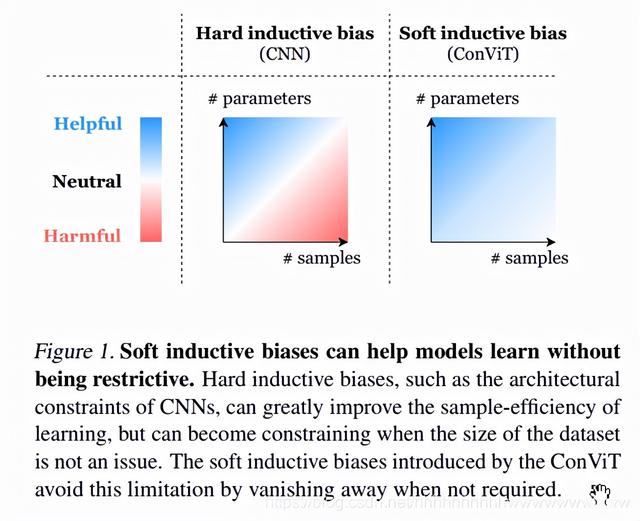

一、简介在过去十年中,深度学习的成功很大程度上得益于具有强大归纳偏差的模型,从而允许跨领域进行有效训练(Mitchell,1980;Goodfellow 等,2016)。自 2012 年 AlexNet 取得成功以来,卷积神经网络 (CNN)(LeCun 等人,1998 年;1989 年)的使用在计算机视觉中无处不在(Krizhevsky 等人,2017 年),体现了这一趋势。归纳偏置以两个对权重的强约束的形式硬编码到 CNN 的架构结构中:局部性和权重共享。通过鼓励平移等方差(无池化层)和平移不变性(有池化层)(Scherer 等人,2010 年;Schmidhuber,2015 年;Goodfellow 等人,2016 年),卷积归纳偏差使模型的样本效率和参数效率更高( Simoncelli 和 Olshausen,2001 年;Ruderman 和 Bialek,1994 年)。类似地,对于基于序列的任务,具有硬编码记忆单元的循环网络已被证明可以简化长程依赖 (LSTM) 的学习,并在各种设置中优于普通循环神经网络(Gers 等人,1999 年;Sundermeyer 等人) al., 2012; Greff et al., 2017)。 然而,近年来纯粹基于注意力的模型的兴起对硬编码归纳偏差的必要性提出了质疑。首次作为序列到序列模型的循环神经网络的附加组件引入(Bahdanau 等人,2014 年),通过 Transformer 模型的出现,注意力已经导致自然语言处理的突破,该模型仅依赖于特定的注意力类型:自我注意力(SA)(Vaswani 等,2017)。在大型数据集上进行预训练时,这些模型的强大性能很快导致基于 Transformer 的方法成为替代 LSTM 等循环模型的默认选择(Devlin 等人,2018 年)。 在视觉任务中,CNN 的局部性会削弱捕获远程依赖的能力,而注意力则不受此限制。陈等人。 (2018) 和 Bello 等人。 (2019) 通过增加注意力的卷积层来利用这种互补性。最近,Ramachandran 等人。 (2019) 进行了一系列实验,用注意力替换了 ResNets 中的部分或全部卷积层,发现性能最好的模型在早期层使用卷积,在后期层使用注意力。由 Dosovitskiy 等人介绍的 Vision Transformer (ViT)。 (2020),通过在像素块的嵌入中执行 SA,完全消除了卷积归纳偏差。 ViT 能够匹配或超过 CNN 的性能,但需要对大量数据进行预训练。最近,数据高效视觉转换器 (DeiT)(Touvron 等人,2020 年)无需对补充数据进行任何预训练,而是依靠从一个卷积teacher中知识蒸馏(Hinton 等人,2015 年)。 软电感偏置ViT 最近的成功表明,虽然卷积约束可以在小数据机制中实现强大的样本效率训练,但它们也可能成为限制,因为数据集大小不是 一个问题。在数据丰富的制度中,硬归纳偏差可能会过于严格,学习最合适的归纳偏差可以证明更有效。因此,从业者面临着一个两难选择,即使用具有高性能下限但由于硬归纳偏差可能导致性能上限较低的卷积模型,还是使用具有较低下限但较高上限的基于自我注意的模型.这种困境导致了以下问题:是否可以两全其美,并在不受其限制的情况下获得卷积归纳偏置的好处(见图 1)?

在这个方向上,一种成功的方法是在“混合”模型中结合两种架构。这些交织或组合卷积层和自注意力层的模型在各种任务中取得了成功(Carion 等,2020;Hu 等,2018a;Ramachandran 等,2019;Chen 等,2020; Locatello 等,2020;Sun 等,2019;Srinivas 等,2021;Wu 等,2020)。另一种方法是知识蒸馏(Hintonet al.,2015),它最近已被应用于将卷积教师的归纳偏差转移到学生转换器(Touvron 等人,2020)。虽然这两种方法提供了一个有趣的折衷方案,但它们会强行将卷积归纳偏差引入 Transformer,可能会以其局限性影响 Transformer。 贡献在本文中,我们向弥合 CNN 和 Transformer 之间的差距迈出了新的一步,提出了一种新方法,可以“轻柔地”将卷积归纳偏置引入 ViT。这个想法是让每个 SA 层决定是否作为卷积层,具体取决于上下文。我们做出以下贡献:

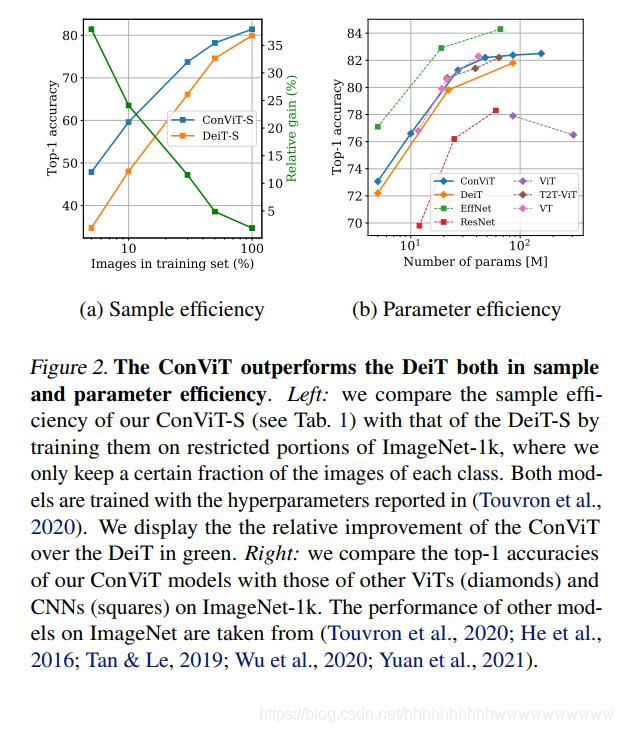

我们提出了一种新形式的 SA 层,称为门控位置自注意力 (GPSA),可以将其初始化为卷积层。 然后,每个注意力头都可以通过调整门控参数来自由恢复表现力。然后我们基于 DeiT (Touvron et al., 2020) 进行实验,将一定数量的 SA 层替换为 GPSA 层。 由此产生的卷积视觉变换器 (ConViT) 优于 DeiT,同时拥有大大提高的样本效率(图 2)。我们定量分析了在 vanilla ViT 中如何自然地鼓励局部注意力,然后研究 ConViT 的内部工作原理并执行消融以研究它如何从卷积初始化中受益。总体而言,我们的工作证明了“软”归纳偏差的有效性,尤其是在学习模型高度不明确的低数据情况下(见图 1),并激发了对诱导它们的进一步方法的探索。 相关工作我们的工作是通过将纯 Transformer 模型(Dosovitskiy 等人,2020 年)的近期成功与 SA 和卷积之间的形式化关系相结合来推动的。事实上,Cordonnier 等人。 (2019) 表明,如果每个头专注于内核补丁中的一个像素,则具有 个头的 SA 层可以表达内核大小的卷积。通过研究在 CIFAR-10 上训练的模型的注意力图的定性方面,表明具有相对位置编码的 SA 层自然地收敛于类似卷积的配置,这表明一定程度的卷积归纳偏差是可取的。 相反,Elsayed 等人已经证明了硬局部约束的限制性。 (2020)。已经采取了多种方法来为 CNN 架构注入非局部性(Hu 等人,2018b;c;Wang 等人,2018 年;Wu 等人,2020 年)。另一条研究线是诱导卷积归纳偏差是不同的架构。例如,Neyshabur (2020) 使用正则化方法鼓励全连接网络 (FCN) 在整个训练过程中从头开始学习卷积。

与我们的方法最相关的是 d’Ascoli 等人。 (2019) 探索了一种将 FCN 网络初始化为 CNN 的方法。这使得最终的 FCN 能够达到比标准初始化所能达到的性能更高的性能。此外,如果 FCN 是从部分训练的 CNN 初始化的,则恢复的自由度允许 FCN 胜过它源自的 CNN。这种方法更普遍地涉及“热启动”方法,例如尖峰张量模型(Anandkumar 等人,2016 年)中使用的方法,其中使用包含问题先验信息的智能初始化来简化学习任务。

再现性我们在以下地址提供了我们方法的开源实现以及预训练模型:https://github.com/facebookresearch/convit。

二. 背景

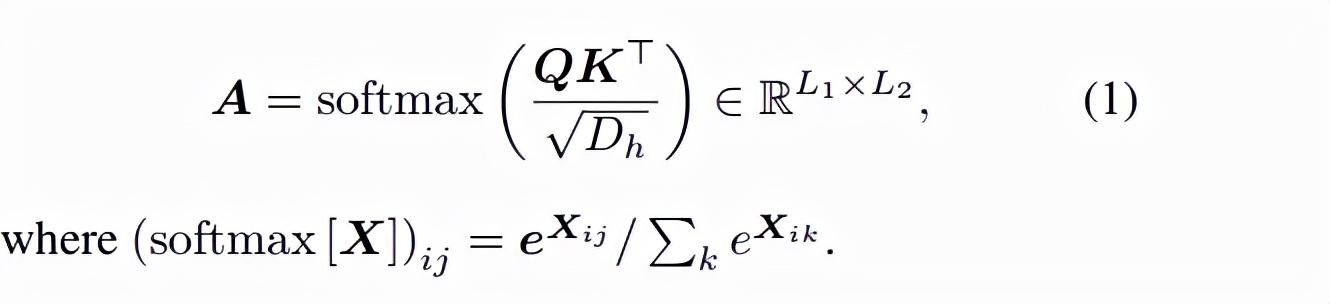

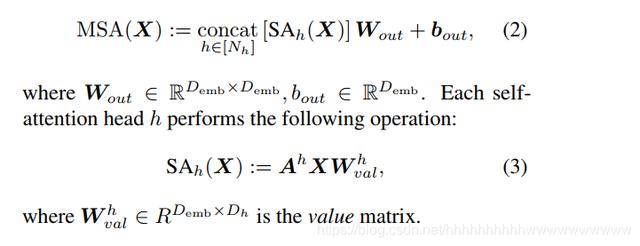

我们首先介绍 SA 层的基础知识,并展示位置注意如何允许 SA 层表达卷积层。 多头自注意力注意力机制基于具有(键、查询)向量对的可训练联想记忆。 使用内积将 “查询”嵌入序列 与另一个“关键”嵌入序列 匹配。 结果是一个注意力矩阵,其条目 (ij) 量化了 与 在语义上的“相关性”:

自注意力是注意力的一种特殊情况,其中序列与其自身匹配,以提取其各部分之间的语义依赖关系。 在 ViT 中,查询和键是 16 × 16 像素块 嵌入的线性投影。 因此,我们有 和 ,其中 , 。 多头 SA 层并行使用多个自注意力头,以允许学习不同类型的相互依赖性。 他们将维度 的 L 个嵌入序列作为输入,并通过以下机制输出 L 个相同维度的嵌入序列:

然而,在方程1。 SA层是位置不可知的:它们不知道补丁是如何根据彼此定位的。 要合并位置信息,有几个选项。 一种是在嵌入时向输入添加一些位置信息,然后再通过 SA 层传播它:(Dosovitskiy 等人,2020)在他们的 ViT 中使用这种方法。 另一种可能性是使用位置自注意力 (PSA) 替换 vanilla SA,使用补丁 i 和 j 的相对位置的编码 (Ramachandran et al., 2019):

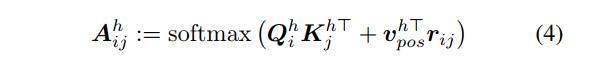

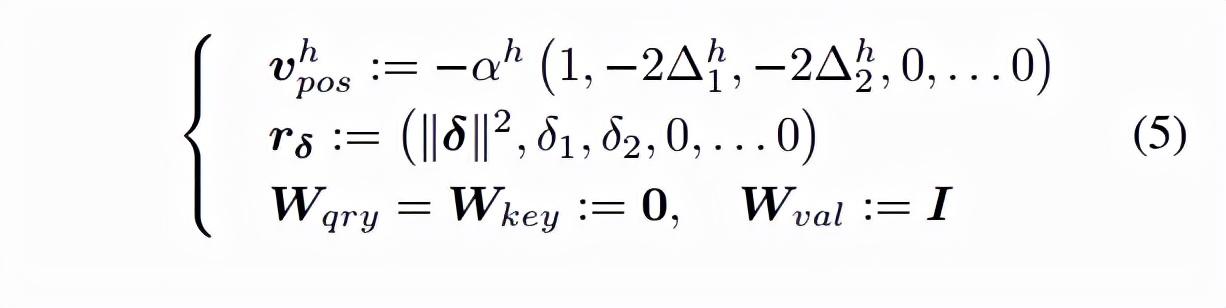

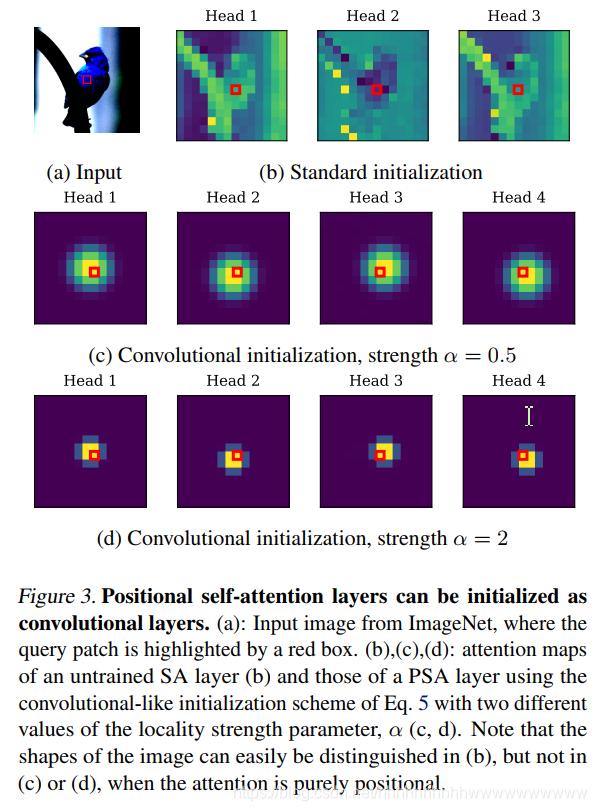

每个注意力头使用一个可训练的嵌入 ,相对位置编码 仅取决于像素 i 和 j 之间的距离,用二维向量 表示。 自注意力作为广义卷积 Cordonnier 等人。 (2019) 表明,具有 个头和维度 ≥ 3 的可学习相对位置编码(方程 4)的多头 PSA 层可以通过设置以下内容来表达滤波器大小为 × 的任何卷积层:

在上面, • 注意力中心 是头部h 最关注的位置,相对于查询补丁。 例如,在图 3(c) 中,四个头从左到右对应于 = (-1; 1); = (-1; -1); = (1; 1); = (1; -1)。 • 局部强度αh > 0 决定了注意力围绕其中心 的集中程度(也可以将其理解为等式1 中softmax 的“温度”)。 当 αh 很大时,注意力只集中在 处的补丁上,如图 3(d)所示; 当 小时,注意力分散到更大的区域,如图 3(c)。

因此,PSA 层可以通过将注意力中心 设置为 × 卷积核的每个可能的位置偏移,并将局部强度 αh 发送到某个大值来实现严格的卷积注意力图。

三. 方法

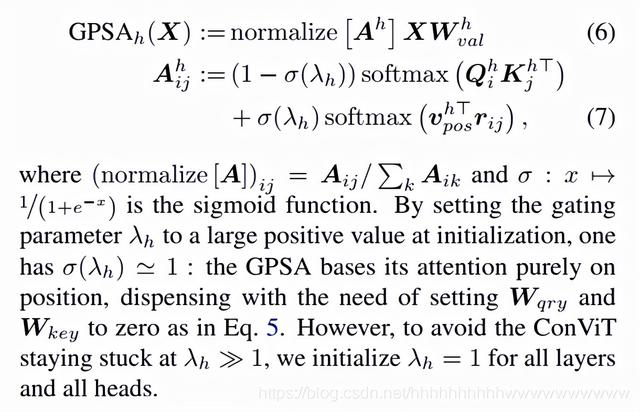

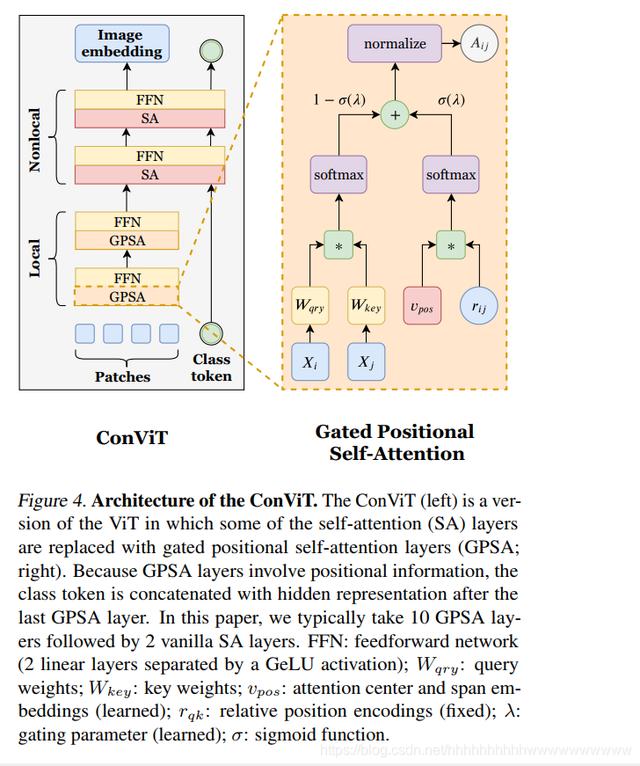

基于 (Cordonnier et al., 2019) 的见解,我们引入了 ConVit,它是 ViT (Dosovitskiy et al., 2020) 的一种变体,它是通过用一种我们称之为门控的新型层替换一些 SA 层而获得的位置自注意(GPSA)层。核心思想是强制执行方程的“知情”卷积配置。 5 在初始化时 GPSA 层,然后让他们决定是否保持卷积。然而,PSA 层的标准参数化(方程 4)受到两个限制,这导致我们两个引入两个修改。 自适应注意力跨度 PSA 中的第一个警告是涉及大量的可训练参数,因为相对位置编码的数量 是补丁数量的二次方。这导致一些作者将注意力限制在查询补丁周围的补丁子集上 (Ramachandran et al., 2019),代价是丢失远程信息。 为了避免这种情况,我们保持相对位置编码 固定,只训练确定注意力头中心和跨度的嵌入 ;这种方法与 Sukhbaatar 等人中引入的自适应注意力范围有关。 (2019) 语言转换器。 和的初始值由方程5给出,我们取 = 3 去除无用的零分量。 多亏了 ,与内容注意力所涉及的参数数量相比,位置注意力所涉及的参数数量可以忽略不计。这是有道理的,因为内容交互本质上比位置交互更容易建模。 位置选通 标准 PSA 的第二个问题是等式中的内容和位置术语。 4 个可能具有不同的量级,在这种情况下,softmax 将忽略两者中最小的一个。特别是,上面讨论的卷积初始化方案涉及高度集中的注意力分数,即 softmax 中的高幅度值。在实践中,我们观察到在 vanilla PSA 层上使用卷积初始化方案可以提高早期阶段的性能,但会降低后期性能,因为注意力机制懒惰地忽略了内容信息(参见 SM.A)。 为了避免这种情况,GPSA 层在 softmax 之后对内容和位置项求和,它们的相对重要性由可学习的门控参数 λh(每个注意力头一个)控制。最后,我们对得到的矩阵总和(其项为正)进行归一化,以确保得到的注意力分数定义了概率分布。因此,生成的 GPSA 层参数化如下 (另请参见图 4):

建筑细节 ViT 将大小为 224 的输入图像切片为 14 × 14 像素的 16 × 16 非重叠块,并使用卷积茎将它们嵌入到维度 = 64 的向量中。然后它通过 12 个块传播补丁,这些块保持它们的维度不变。每个块由一个 SA 层和一个带有 GeLU 激活的 2 层前馈网络 (FFN) 组成,两者都配备了残差连接。 ConViT 只是一个 ViT,其中前 10 个块通过卷积初始化用 GPSA 层替换 SA 层。

类似于 BERT 等语言转换器(Devlin 等人,2018),ViT 使用一个额外的“类标记”,附加到补丁序列来预测输入的类。由于此类令牌不携带任何位置信息,因此 ViT 的 SA 层不使用位置注意:通过添加维度 Demb 的可学习位置嵌入,位置信息被注入到第一层之前的每个补丁中。由于 GPSA 层涉及位置注意,因此它们不太适合类令牌方法。我们通过将类标记附加到最后一个 GPSA 层之后的补丁来解决这个问题,类似于 (Touvron et al., 2021b)(见图 4)1 中所做的。 为了公平起见,并且由于它们的计算成本较低,我们将 ViT 的绝对位置嵌入保持在 ConViT 中。但是,如SM所示。 F,ConViT 对它们的依赖要少得多,因为 GPSA 层已经使用了相对位置编码。因此,可以轻松删除绝对位置嵌入,无需在更改输入分辨率时对嵌入进行插值(只需根据等式 5 重新采样相对位置编码,就像在我们的开源实现中自动执行的那样)。 训练详情 我们的 ConVit 基于 DeiT(Touvron 等人,2020 年),这是 ViT 的超参数优化版本,已开源2。 由于能够在不使用任何外部数据的情况下获得有竞争力的结果,DeiT 既是一个出色的基线,又相对容易训练:最大的模型 (DeiT-B) 只需要在 8 个 GPU 上进行几天的训练。

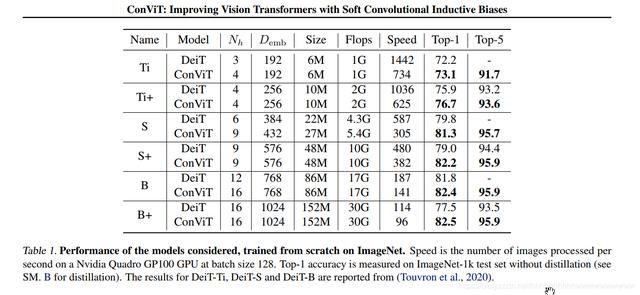

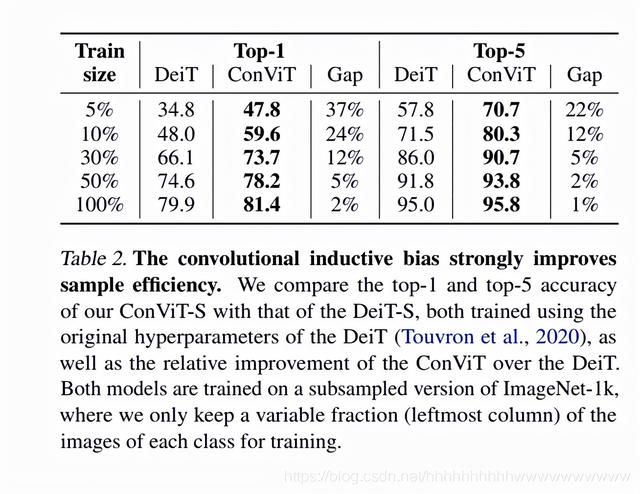

为了模拟 2 × 2、3 × 3 和 4 × 4 卷积滤波器,我们考虑了具有 4、9 和 16 个注意力头的三种不同的 ConViT 模型(见表 1)。 它们的磁头数量略大于 Touvron 等人的 DeiT-Ti、ConViT-S 和 ConViT-B。 (2020),分别使用了 3、6 和 12 个注意力头。 为了获得相似尺寸的模型,我们使用两种比较方法。 • 与 Touvron 等人建立直接比较。 (2020),我们将 ConViT 的嵌入维度降低到 = 48,而不是用于 DeiT 的 64。重要的是,我们保持 (Touvron et al., 2020) 中呈现的所有超参数(调度、数据增强、正则化)不变,以实现公平比较。生成的模型被命名为 ConViT-Ti、ConViT-S 和 ConViT-B。 • 我们还使用相同数量的头部和 = 64 训练 DeiTs 和 ConViT,以确保 ConViT 带来的改进不仅仅是由于更多的头部(Touvron 等,2021b)。这导致稍大的模型在 表1 中用“+”表示。为了在 8 个 GPU 上拟合这些模型的同时保持稳定的训练,我们将学习率从 0:0005 降低到 0:0004,将批量大小从 1024 降低到 512。这些最小的超参数变化导致 DeiTB+ 的表现不如 DeiT-S+ ,这不是 ConViT 的情况,表明对超参数变化具有更高的稳定性。 ConViT 的性能 在表1中,我们展示了这些模型在经过 300 轮训练后在 ImageNet 测试集上评估的前 1 名准确率,以及它们的参数数量、触发器数量和吞吐量。每个 ConViT 的性能都优于其相同大小和相同失败次数的 DeiT。重要的是,尽管位置自注意力确实减慢了 ConViTs 的吞吐量,但它们在同等吞吐量下也优于 DeiTs。例如,ConViT-S+ 达到 82:2% 的前 1,以更少的参数和更高的吞吐量超越原始 DeiT-B。无需任何调整,ConViT 在 CIFAR100 上也达到了高性能,参见 SM。 C,我们还报告了学习曲线。 请注意,我们的 ConViT 与 Touvron 等人介绍的蒸馏方法兼容。 (2020) 无需额外费用。如SM.B所示、硬蒸馏提高了性能,使硬蒸馏的 ConViT-S+ 达到 82:9% 的 top-1 准确率,与硬蒸馏的 DeiTB 相同,参数数量减半。然而,虽然蒸馏需要额外的正向通过 在训练的每一步都预先训练 CNN,ConViT 没有这样的要求,在没有额外计算要求的情况下提供与蒸馏类似的好处。 ConViT 的样本效率在表2中,我们以系统的方式研究了 ConViT 的样本效率,通过对 ImageNet-1k 数据集的每一类进行子采样 f = f0:05; 0:1; 0:3; 0:5; 1g,同时将时代数乘以 1=f,以便呈现给模型的图像总数保持不变。正如人们所料,DeiT-S 及其 ConViT-S 对应物的 top-1 准确度随着 f 的减小而下降。然而,ConViT 受到的影响要小得多:虽然只训练了 10% 的数据,但 ConVit 达到了 59.5% 的 top-1 准确率,而其 DeiT 对应的则为 46.5%。 这个结果可以直接与 (Zhai et al., 2019) 进行比较,后者在测试了数千个卷积模型后达到了 56.4% 的 top-1 准确率;因此,ConViT 在样品效率方面具有很强的竞争力。这些发现证实了我们的假设,即卷积归纳偏差对小数据集最有帮助,如图 1 所示。

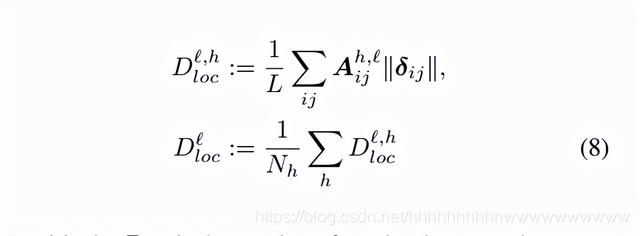

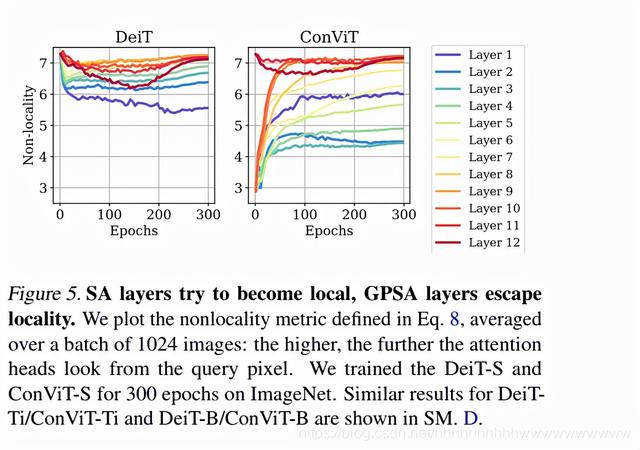

四. 考察地方的作用在本节中,我们证明在标准 SA 层中自然会鼓励局部性,并检查 ConViT 如何从初始化时强加的局部性中受益。 SA 层被拉向局部 我们首先调查在训练过程中自然鼓励 PSA 层变得“局部”的假设(Cordonnier 等人,2019)是否适用于 ViT 中使用的 vanilla SA 层,这些层没有从位置注意力中受益。为了量化这一点,我们通过对每个查询补丁 i 与所有关键补丁 j 的距离 求和来定义“非局部性”的度量,这些关键补丁 j 由它们的注意力得分 加权。我们对查询补丁上获得的数字进行平均以获得头 h 的非局部性度量,然后可以在注意力头上平均以获得整个层的非局部性:

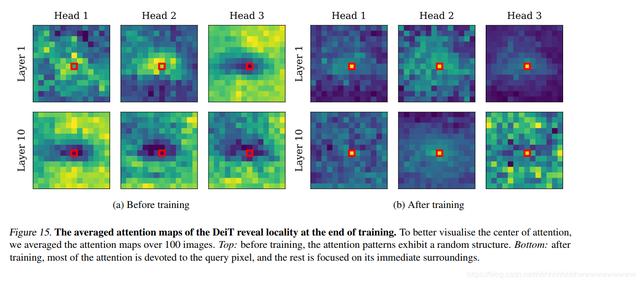

直观地说, 是注意力中心和查询补丁之间的补丁数量:注意力头离查询补丁越远,非局部性就越高。在图 5(左图)中,我们展示了在 ImageNet 上训练了 300 个 epoch 的 DeiT-S 的 12 层训练期间非局部性度量如何演变。在最初的几个 epoch 中,非局部性在所有层中都从其初始值下降,这证实了 DeiT 变得更加“卷积”。在训练的后期阶段,非局部性度量对于较低层保持较低,并逐渐上升到较高层,表明后者捕获了长期依赖关系,正如在语言转换器中观察到的那样(Sukhbaatar 等人,2019 年)。

在检查注意力图(SM 的图 15)时,这些观察结果特别清楚,并指出局部性在较低层中的有益影响。

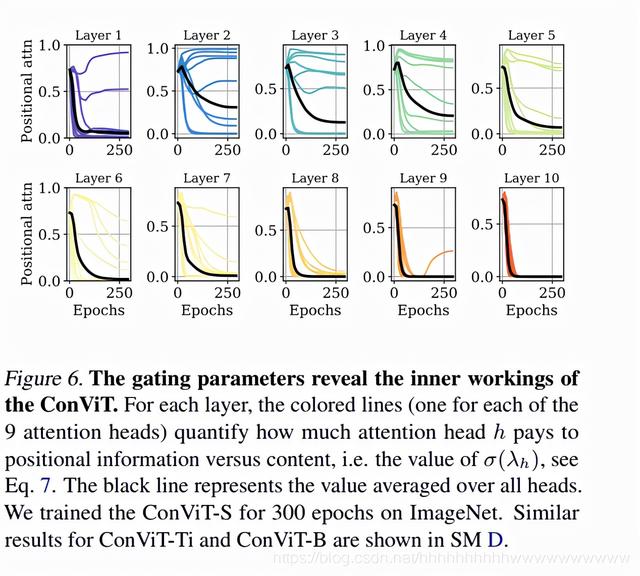

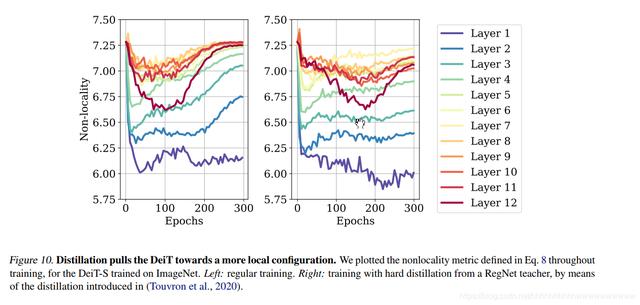

在 SM. 的图 10 中,我们还表明,当使用 Touvron 等人的卷积网络进行蒸馏训练时,非局部性度量较低。 (2020),表明教师的位置部分转移到学生(Abnar et al.,2020)。 GPSA 层逃逸局部性 在 ConViT 中,由于卷积初始化,在 GPSA 层的训练开始时施加了强局部性。 在图 5(右图)中,我们看到这种局部配置在整个训练过程中都被转义了,因为非局部性度量在所有 GPSA 层中都在增长。 然而,训练结束时的非局部性低于 DeiT 达到的非局部性,表明在整个训练过程中保留了一些关于初始化的信息。 有趣的是,最终的非局部性不会像 DeiT 那样在整个层中单调增加。 第一层和最后一层强烈地逃避局部性,而中间层(特别是第二层)保持更多的局部性。 为了获得更多的理解,我们检查了图 6 中门控参数的动态。我们看到,在所有层中,平均门控参数 Ehσ(λh)(黑色),它反映了对位置信息的平均关注量与内容,在整个培训期间减少。该数量在第 6-10 层达到 0,这意味着实际上忽略了位置信息。然而,在第 1-5 层中,一些注意力头保持较高的 σ(λh) 值,因此利用了位置信息。有趣的是,ConViT-Ti 只使用位置信息直到第 4 层,而 ConViT-B 使用它直到第 6 层(参见 App.D),这表明更大的模型——更不明确——从卷积中获益更多事先的。这些观察结果突出了门控参数在可解释性方面的有用性。

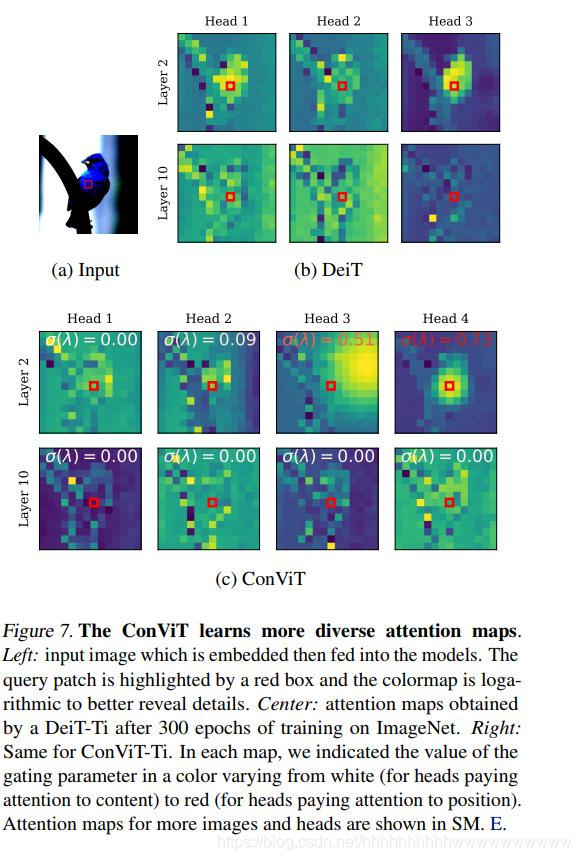

图 7 的注意力图进一步揭示了 ConViT 的内部工作原理,它是通过将嵌入的输入图像传播到各层并在图像的中心选择查询块来获得的。在第 10 层(底行)中,DeiT 和 ConViT 的注意力图看起来性质相似:它们都执行基于内容的注意力。然而,在第 2 层(顶行),ConViT 的注意力图更加多样化:一些 head 关注内容(heads 1 和 2),而另一些则主要关注位置(heads 3 和 4)。在专注于位置的头部中,一些保持高度局部化(头部 4),而另一些则扩大了他们的注意力范围(头部 3)。感兴趣的读者可以在SM中找到更多的注意力图 E

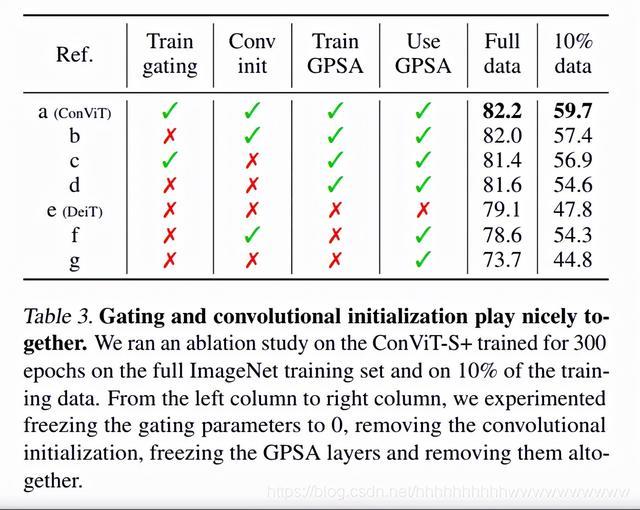

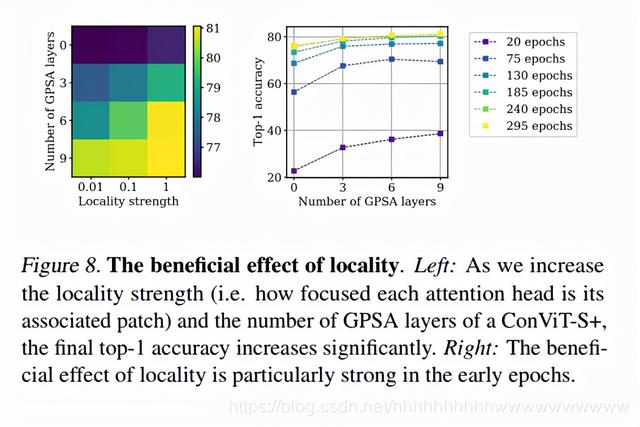

强大的地方性是可取的 我们接下来研究 ConViT 的性能如何受到 ConViT 的两个重要超参数的影响:局部强度 α,它决定了头部围绕其注意力中心的聚焦程度,以及由 GPSA 层替换的 SA 层的数量。 我们检查了这些超参数对 ConViT-S 的影响,在 ImageNet 的前 100 类上进行了训练。 如图 8(a)所示,最终测试精度随着局部强度和 GPSA 层数的增加而增加; 换句话说,卷积越多越好。 在图 8(b) 中,我们展示了在不同训练阶段的性能如何受到 GPSA 层的影响。我们看到,在训练的早期阶段,GPSA 带来的提升特别强:在 20 个 epoch 之后,使用 9 个 GPSA 层导致测试精度几乎翻倍,这表明卷积初始化为模型提供了实质性的“领先优势”。除了最终性能的提升之外,这种加速本身就具有实际意义。 消融研究 在表3中,我们在 ConViT 上进行了消融,表示为 [a]。我们尝试去除位置门控 [b]4、卷积初始化 [c]、门控和卷积初始化 [d] 以及 GPSA([e],这给我们留下了一个简单的 DeiT)。 令人惊讶的是,在完整的 ImageNet 上,没有门控 [d] 的 GPSA 已经比 DeiT (+2.5) 带来了实质性的好处,而卷积初始化 ([b], +2.9) 略微增加了 DeiT。至于门控,它在存在卷积初始化([a],+3.1)的情况下有一点帮助,否则就无济于事。由于门控和卷积初始化(可能是由于性能饱和度超过 80% top-1),这些轻微的改进在低数据状态下变得更加清晰。在这里,仅 GPSA 就带来了 +6.8,额外的 +2.3 来自门控,+2.8 来自卷积初始化,+5.1 来自两者,说明了它们的互补性。 我们还研究了在所有 GPSA 层都被冻结的情况下 ConViT 的性能,只留下 FFN 在前 10 层中进行训练。正如人们所料,如果我们随机初始化 GPSA 层([f],与 DeiT 相比为 -5.4),则在完整数据机制中的性能会严重下降。然而,卷积初始化显着地使冻结的 ConViT 达到了非常不错的性能,几乎等于 DeiT 的性能([e],-0.5)。换句话说,用随机“卷积”替换 SA 层几乎不会影响性能。在低数据情况下,冻结的 ConViT 甚至比 DeiT 的表现还要好 (+6.5)。这自然引出了一个问题:注意力是否真的是 ViT 成功的关键(Dong 等,2021;Tolstikhin 等,2021;Touvron 等,2021a)。

五、结论与展望目前的工作调查了初始化和归纳偏差在视觉转换器学习中的重要性。通过展示人们可以以一种软的方式利用卷积约束,我们融合了架构先验和表达能力的好处。结果是一个简单的配方,可以提高可训练性和样本效率,而无需增加模型大小或需要任何调整。我们的方法可以总结如下:不是像在混合模型中那样将卷积层与 SA 层交织在一起,而是让这些层通过调整一组门控参数来决定是否进行卷积。更一般地,结合不同架构的偏差并让模型选择最适合给定任务的偏差可能成为一个有希望的方向,减少贪婪架构搜索的需要,同时提供更高的可解释性。在未来的工作中将探索的另一个方向如下:如果 SA 层从初始化为随机卷积中受益,可以通过将它们初始化为预训练卷积来更大幅度地降低它们的样本复杂度。 致谢 我们感谢 Herve J´ egou 和 Francisco Massa 的有益讨论。 SD 和 GB 承认法国政府在 Agence Nationale de la Recherche 管理下的资金,作为“Investissements d'avenir”计划的一部分,参考 ANR-19-P3IA-0001(PRAIRIE 3IA 研究所)。

本文 麒麟点评 原创,转载保留链接!网址:http://kylinpackage.com.cn/dianping/11045.html

1.本站遵循行业规范,任何转载的稿件都会明确标注作者和来源;2.本站的原创文章,请转载时务必注明文章作者和来源,不尊重原创的行为我们将追究责任;3.作者投稿可能会经我们编辑修改或补充。